카테고리 없음

Distiller, Using the sample application

SciomageLAB

2024. 10. 18. 00:17

반응형

Using the sample application

Distiller 저장소에는 샘플 애플리케이션이 포함되어 있습니다.distiller/examples/classifier_compression/compress_classifier.py, 그리고 Distiller의 기능을 보여주는 일정 파일 세트가 있습니다. 다음은 이 응용 프로그램을 사용하는 방법과 함께 제공되는 일정에 대한 간략한 설명입니다.

다음 리소스를 참조 할 수도 있습니다.

샘플 애플리케이션은 이미지 분류 DNN 압축을 위한 다양한 기능을 지원하고 자체 애플리케이션에 distiller를 통합하는 방법의 예를 제공합니다. 코드는 문서화 되어 있으며 최고의 문서 소스로 간주 되어야 하지만 여기에서 몇 가지 세부 정보를 제공합니다.

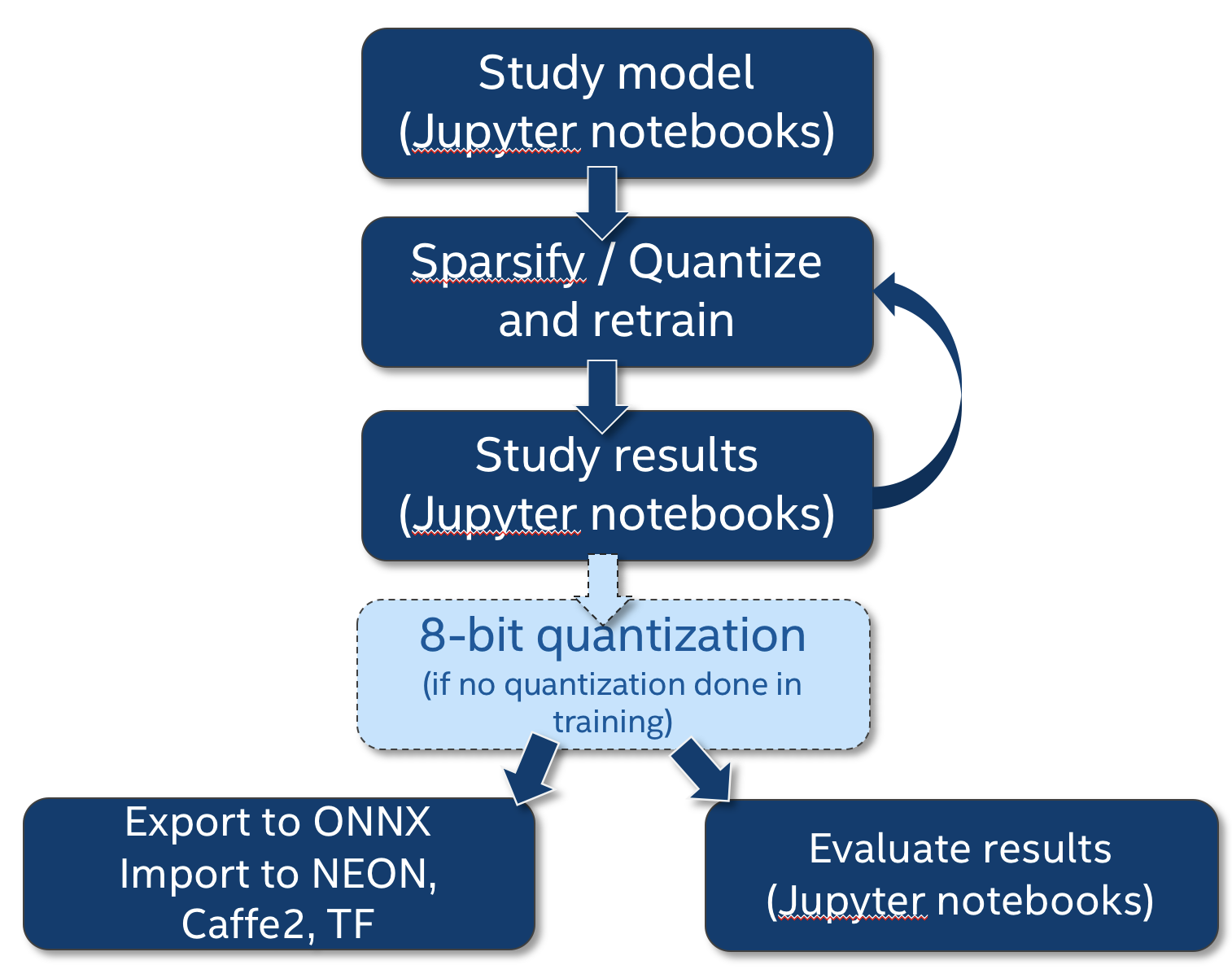

이 다이어그램은 compress_classifier.py가 압축 워크 플로에서 어떻게 적용되는지, 그리고 우리가 연구 작업의 일부로 Jupyter 노트북을 통합하는 방법을 보여줍니다.

# Command line arguments

# Command line arguments

command line에 대한 도움말을 보려면 다음을 호출하십시오.

$ python3 compress_classifier.py --help예를 들면 :

$ time python3 compress_classifier.py -a alexnet --lr 0.005 -p 50 ../../../data.imagenet -j 44 --epochs 90 --pretrained --compress=../sensitivity-pruning/alexnet.schedule_sensitivity.yaml

Parameters:

+----+---------------------------+------------------+---------------+----------------+------------+------------+----------+----------+----------+------------+---------+----------+------------+

| | Name | Shape | NNZ (dense) | NNZ (sparse) | Cols (%) | Rows (%) | Ch (%) | 2D (%) | 3D (%) | Fine (%) | Std | Mean | Abs-Mean |

|----+---------------------------+------------------+---------------+----------------+------------+------------+----------+----------+----------+------------+---------+----------+------------|

| 0 | features.module.0.weight | (64, 3, 11, 11) | 23232 | 13411 | 0.00000 | 0.00000 | 0.00000 | 0.00000 | 0.00000 | 42.27359 | 0.14391 | -0.00002 | 0.08805 |

| 1 | features.module.3.weight | (192, 64, 5, 5) | 307200 | 115560 | 0.00000 | 0.00000 | 0.00000 | 1.91243 | 0.00000 | 62.38281 | 0.04703 | -0.00250 | 0.02289 |

| 2 | features.module.6.weight | (384, 192, 3, 3) | 663552 | 256565 | 0.00000 | 0.00000 | 0.00000 | 6.18490 | 0.00000 | 61.33445 | 0.03354 | -0.00184 | 0.01803 |

| 3 | features.module.8.weight | (256, 384, 3, 3) | 884736 | 315065 | 0.00000 | 0.00000 | 0.00000 | 6.96411 | 0.00000 | 64.38881 | 0.02646 | -0.00168 | 0.01422 |

| 4 | features.module.10.weight | (256, 256, 3, 3) | 589824 | 186938 | 0.00000 | 0.00000 | 0.00000 | 15.49225 | 0.00000 | 68.30614 | 0.02714 | -0.00246 | 0.01409 |

| 5 | classifier.1.weight | (4096, 9216) | 37748736 | 3398881 | 0.00000 | 0.21973 | 0.00000 | 0.21973 | 0.00000 | 90.99604 | 0.00589 | -0.00020 | 0.00168 |

| 6 | classifier.4.weight | (4096, 4096) | 16777216 | 1782769 | 0.21973 | 3.46680 | 0.00000 | 3.46680 | 0.00000 | 89.37387 | 0.00849 | -0.00066 | 0.00263 |

| 7 | classifier.6.weight | (1000, 4096) | 4096000 | 994738 | 3.36914 | 0.00000 | 0.00000 | 0.00000 | 0.00000 | 75.71440 | 0.01718 | 0.00030 | 0.00778 |

| 8 | Total sparsity: | - | 61090496 | 7063928 | 0.00000 | 0.00000 | 0.00000 | 0.00000 | 0.00000 | 88.43694 | 0.00000 | 0.00000 | 0.00000 |

+----+---------------------------+------------------+---------------+----------------+------------+------------+----------+----------+----------+------------+---------+----------+------------+

2018-04-04 21:30:52,499 - Total sparsity: 88.44

2018-04-04 21:30:52,499 - --- validate (epoch=89)-----------

2018-04-04 21:30:52,499 - 128116 samples (256 per mini-batch)

2018-04-04 21:31:04,646 - Epoch: [89][ 50/ 500] Loss 2.175988 Top1 51.289063 Top5 74.023438

2018-04-04 21:31:06,427 - Epoch: [89][ 100/ 500] Loss 2.171564 Top1 51.175781 Top5 74.308594

2018-04-04 21:31:11,432 - Epoch: [89][ 150/ 500] Loss 2.159347 Top1 51.546875 Top5 74.473958

2018-04-04 21:31:14,364 - Epoch: [89][ 200/ 500] Loss 2.156857 Top1 51.585938 Top5 74.568359

2018-04-04 21:31:18,381 - Epoch: [89][ 250/ 500] Loss 2.152790 Top1 51.707813 Top5 74.681250

2018-04-04 21:31:22,195 - Epoch: [89][ 300/ 500] Loss 2.149962 Top1 51.791667 Top5 74.755208

2018-04-04 21:31:25,508 - Epoch: [89][ 350/ 500] Loss 2.150936 Top1 51.827009 Top5 74.767857

2018-04-04 21:31:29,538 - Epoch: [89][ 400/ 500] Loss 2.150853 Top1 51.781250 Top5 74.763672

2018-04-04 21:31:32,842 - Epoch: [89][ 450/ 500] Loss 2.150156 Top1 51.828125 Top5 74.821181

2018-04-04 21:31:35,338 - Epoch: [89][ 500/ 500] Loss 2.150417 Top1 51.833594 Top5 74.817187

2018-04-04 21:31:35,357 - ==> Top1: 51.838 Top5: 74.817 Loss: 2.150

2018-04-04 21:31:35,364 - Saving checkpoint

2018-04-04 21:31:39,251 - --- test ---------------------

2018-04-04 21:31:39,252 - 50000 samples (256 per mini-batch)

2018-04-04 21:31:51,512 - Test: [ 50/ 195] Loss 1.487607 Top1 63.273438 Top5 85.695312

2018-04-04 21:31:55,015 - Test: [ 100/ 195] Loss 1.638043 Top1 60.636719 Top5 83.664062

2018-04-04 21:31:58,732 - Test: [ 150/ 195] Loss 1.833214 Top1 57.619792 Top5 80.447917

2018-04-04 21:32:01,274 - ==> Top1: 56.606 Top5: 79.446 Loss: 1.893command line을 다시 살펴 보겠습니다.

$ time python3 compress_classifier.py -a alexnet --lr 0.005 -p 50 ../../../data.imagenet -j 44 --epochs 90 --pretrained --compress=../sensitivity-pruning/alexnet.schedule_sensitivity.yaml이 예에서는 다음 구성을 사용하여 TorchVision 사전 훈련 된 AlexNet 네트워크를 정리합니다.

- Learning-rate of 0.005

- 50 개의 미니 배치마다 진행률을 인쇄합니다.

- 44개의 worker threads를 사용하여 데이터를 로드합니다 (머신에 적합한 것을 사용해야 합니다).

- Run for 90 epochs. Torchvision의 사전 훈련 된 모델은 epoch 메타 데이터를 저장하지 않았으므로 epoch 0에서 프루닝이 시작됩니다. 자체 네트워크를 훈련하고 정리하면 마지막 훈련 시대가 모델과 함께 메타 데이터로 저장됩니다. 따라서 이러한 모델을 로드 할 때 첫 번째 Epoch는 0이 아니라 마지막 훈련 Epoch입니다.

반응형